"La seguridad de nuestros hijos no está en venta": ya está aquí la primera ley que regula los 'amigos IA'

El debate sobre los efectos de la IA en la salud mental está empezando a transformarse en medidas tangibles. OpenAI anunció el control parental de ChatGPT tras la demanda por el suicidio de un adolescente y ahora tenemos la primera ley que regula a los llamados amigos o compañeros IA popularizados por apps como Replika o Character.AI.

Qué ha pasado. El gobernador de California, Gavin Newsom, acaba de firmar la primera ley para controlar los compañeros IA, tal y como cuentan en TechCrunch. “Podemos seguir liderando el campo de la inteligencia artificial y la tecnología, pero debemos hacerlo de forma responsable, protegiendo a nuestros hijos en cada paso del camino. La seguridad de nuestros hijos no está en venta”, aseguró el gobernador en un comunicado.

Por qué es importante. Hay otras propuestas sobre la mesa en Estados Unidos, pero California es el primer estado que eleva a ley el asunto de los compañeros IA. Los riesgos de usar este tipo de chatbots, especialmente entre los adolescentes, ya no son advertencias de los expertos, ahora habrá consecuencias legales. Las empresas que no cumplan las normas podrán enfrentarse a multas de hasta 250.000 dólares.

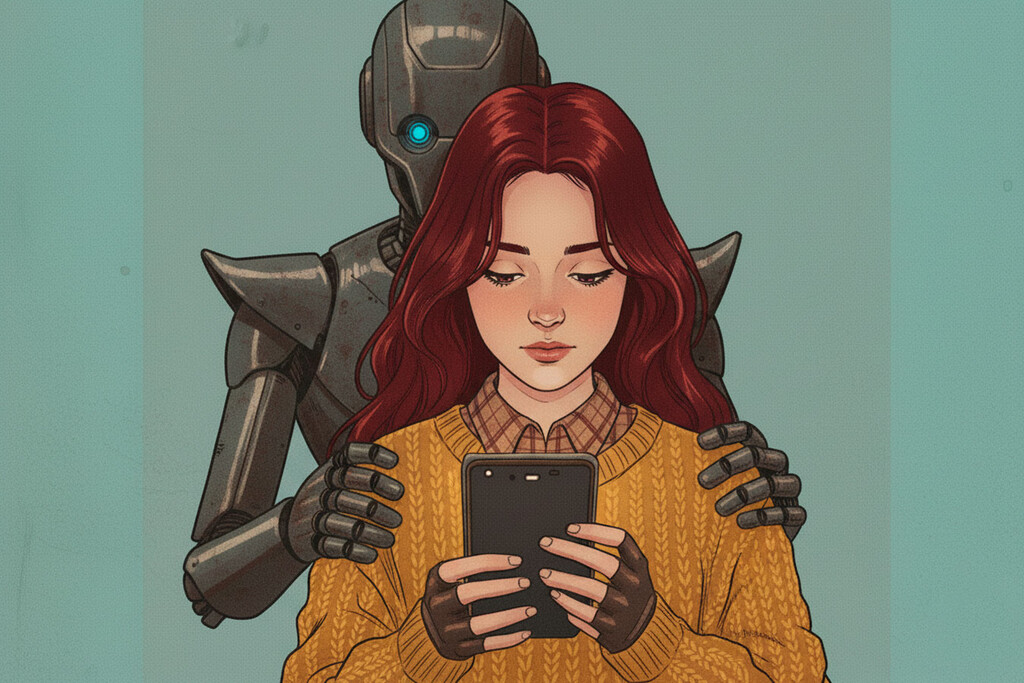

Qué es un compañero IA. Son chatbots que buscan replicar una conexión humana y pueden ofrecer desde apoyo emocional hasta relaciones íntimas. Por su diseño, son la forma de IA más sensible en cuanto a posibles efectos sobre la salud mental. Las apps más populares son Replika y Character.AI, pero también hay quien entabla este tipo de conexiones con chatbots IA “normales” como ChatGPT o Claude. Incluso existen empresas que “resucitan” a un ser querido con el uso de IA para ayudar a sobrellevar el duelo (aunque los expertos creen que se consigue justo lo contrario).

Qué dice la ley. Entrará en vigor el 1 de enero de 2026 y está pensada especialmente para proteger a los usuarios más jóvenes. Entre las medidas que incluye está la obligación de que las empresas integren sistemas de verificación de edad. Además, deberán mostrar advertencias que dejen claro a los usuarios que las interacciones están generadas por IA, así como integrar protocolos de detección de suicidio o autolesiones.

Otras medidas. Como decíamos al principio, la demanda de los padres del adolescente que discutió sus planes de suicidio con ChatGPT desató una crisis en OpenAI, que pronto anunció nuevas salvaguardas para ChatGPT como el control parental. Las apps de compañeros IA también están llevando este tema a su discurso. Character AI ya cuenta con herramientas parentales y Replika aseguró a TechCrunch que dedican muchos recursos para filtrar contenido y dirigir a usuarios en situaciones complicadas a líneas de ayuda.

En Xataka | Los humanos nos estamos enamorando de IAs y no son casos aislados: ya se cuentan por miles

-

La noticia "La seguridad de nuestros hijos no está en venta": ya está aquí la primera ley que regula los 'amigos IA' fue publicada originalmente en Xataka por Amparo Babiloni .

Fuente: Xataka

Enlace: "La seguridad de nuestros hijos no está en venta": ya está aquí la primera ley que regula los 'amigos IA'

Comentarios

Publicar un comentario