La resbaladiza cuesta de Apple en el análisis de fotos de abusos infantiles

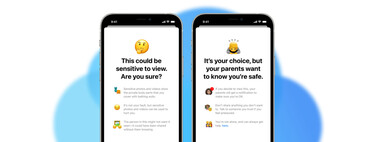

Apple anunció ayer una herramienta de escaneo de fotos para buscar abusos a menores de edad en EEUU. Tres medidas que cuyo funcionamiento hemos explicado en profundidad, cuyos detalles no han evitado la polémica. El centro de la misma gira en torno a la posibilidad de que estas medidas sean reutilizadas para cualquier otro tipo de contenido.

El uso más evidente es el de atajar la disidencia política y amenazar las libertades de la población en países autoritarios. Países como Arabia Saudí, China, Venezuela y demás regímenes son los que podrían aprovecharse de estas nuevas herramientas pero, ¿qué posibilidades hay de que esto se convierta en realidad?

¿Un primer paso para el escaneo de cualquier contenido en el iPhone?

Tan solo bastaría que Apple expandiese los parámetros de aprendizaje automático y buscar tipos de contenidos adicionales o que alterase la configuración de las alertas a escanear, incluyendo no solo cuentas de niños sino la de cualquier usuario para que la estrecha puerta trasera que Apple está construyendo se hiciera más ancha.

En este párrafo escrito por la Electronic Frontier Foundation critica los planes de Apple en su cifrado para construir una puerta trasera en nuestra vida privada. Ciertamente, aquí está una gran parte de los problemas que plantean los críticos con esta medida.

El argumento es que si Apple puede escanear fotos on-device antes de que se cifren, revisar la alerta y avisar a un organismo, ¿qué le impide hacerlo con mensajes, enlaces, webs visitadas y demás contenido privado? Más cuando la base de datos con hashes a revisar los proporciona un tercero, en este caso la Child Sexual Abuse Material (CSAM) mantenida por el National Center for Missing & Exploited Children (NCMEC). En otros países bien podría haber un organismo que, además de pornografía infantil, cuele fotos de consignas disidentes, manifestaciones, posters y resto de contenido subversivo. No suena descabellado.

Whoever controls this list can search for whatever content they want on your phone, and you don’t really have any way to know what’s on that list because it’s invisible to you (and just a bunch of opaque numbers, even if you hack into your phone to get the list.)

— Matthew Green (@matthew_d_green) August 5, 2021

El profesor de cristología en la Universidad Johns Hopkins, Matthew Green, se mostró muy crítico estos días con las medidas que va a tomar Apple. Y precisamente apunta hacia ese punto débil, en el que incluso si confiamos en Apple, el responsable de esa base de datos es quien realmente tiene el poder en sus manos. Otros, como el profesor de ingeniería de seguridad en la Universidad de Cambridge Ross Anderson, apuntan a que las medidas simplemente convierten la vigilancia de ciudadanos en masa a una vigilancia distribuida que se ejecuta en los dispositivos en vez de en la nube.

Estos sistemas llevan en marcha más de una década

En la otra cara de la moneda, lo cierto es que el escaneo de fotos en busca de abusos infantiles no es nueva. Sí lo es que se haga desde el propio dispositivo del usuario, en vez de la nube. Pero empresas del sector tecnológico llevan revisando fotos en busca de abusos infantiles mediante hashing desde hace más de una década.

Google, por ejemplo, lleva utilizando el hashing para identificar pornografía infantil desde 2008. Microsoft desarrolló la conocida base de datos PhotoDNA que emplea el hashing en 2009, utilizándose en todos sus servicios en la nube. También se encuentra en uso por Twitter, Gmail, Facebook, Adobe, Reddit y Discord, incluyendo la propia NCMEC. Apple lleva desde al menos 2019 analizando en la nube las fotos subidas a iCloud con las mismas técnicas.

AIUI the database can’t be altered arbitrarily, and has existed for more than a decade without that sort of thing happening on photos in the cloud at all. I think this is describing a theoretical risk that ignores how authoritarian governments actually don’t need excuses.

— Charles Arthur (@charlesarthur) August 5, 2021

Tal y como cuenta el periodista tecnológico Charles Arthur, quien cubrió este tipo de tecnologías en su paso por The Guardian, estas tecnologías llevan más de una década aplicándose. Y en ningún momento se ha visto un abuso de las mismas por parte de gobiernos autoritarios. En parte y como explica Arthur:

for this scenario to work, the government needs to know the photo that’s on the person’s phone and upload a version of that to the database. That’s ludicrous. How do they get them to create the hash? They’ll just arrest them on a pretext. That’s what dictators do.

— Charles Arthur (@charlesarthur) August 5, 2021

Un gobierno autoritario no necesita de excusas para detener a un sospechoso. Simplemente lo detiene porque para eso es una dictadura. Para que un gobierno tuviese el pretexto, necesitaría conocer de antemano la foto en cuestión y que ésta estuviera en el dispositivo del usuario, antes de subirla a la base de datos.

Perseguir la pornografía infantil debe ser una prioridad de las empresas tecnológicas, notificando los infractores ante las autoridad y ahuyentando el uso de sus servicios para su divulgación. Todo parece indicar que este nuevo método es una forma adicional de luchar contra esta lacra. Dado lo que hemos visto, no hay casos de abuso de estas herramientas, pues no parece práctico para un régimen autoritario.

-

La noticia La resbaladiza cuesta de Apple en el análisis de fotos de abusos infantiles fue publicada originalmente en Applesfera por Eduardo Archanco .

Fuente: Applesfera

Enlace: La resbaladiza cuesta de Apple en el análisis de fotos de abusos infantiles

Comentarios

Publicar un comentario